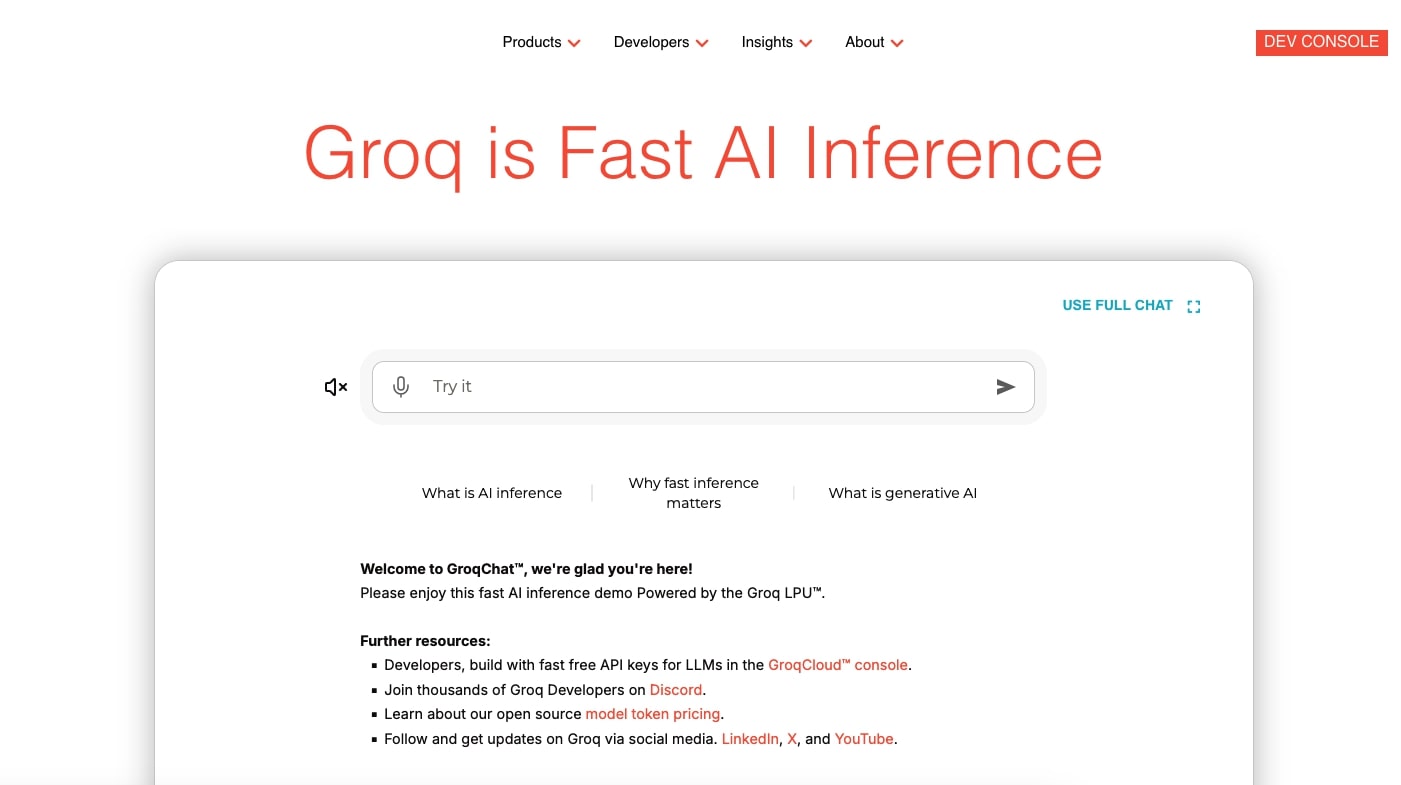

Vous cherchez à déployer des applications IA performantes sans compromettre la vitesse ou l’environnement ? Imaginez une technologie capable de traiter des modèles d’intelligence artificielle à une vitesse fulgurante tout en réduisant l’empreinte énergétique. Groq, avec son LPU™ Inference Engine, offre une inférence IA de pointe, conçue et fabriquée en Amérique du Nord. Dans cet article, découvrez ses fonctionnalités, ses tarifs, les avis des utilisateurs et des alternatives pour propulser vos projets IA.

Qu’est-ce que Groq ?

Groq, basé dans la Silicon Valley depuis 2016, est un pionnier de l’inférence IA, offrant des solutions cloud et sur site pour des applications à grande échelle. Son unité de traitement linguistique (LPU) surpasse les GPU traditionnels en vitesse, qualité et efficacité énergétique, exécutant des modèles comme Llama, Mixtral ou Gemma avec une latence minimale. Conçus, fabriqués et assemblés en Amérique du Nord, les systèmes Groq garantissent une qualité industrielle et une fiabilité exceptionnelle. En 2025, Groq se distingue par ses performances record (jusqu’à 263 tokens/seconde pour Llama 3 70B) et sa compatibilité avec les API OpenAI, permettant une intégration fluide. Cet outil s’adresse aux développeurs, entreprises technologiques et innovateurs cherchant à déployer des chatbots, des analyses en temps réel ou des systèmes IA embarqués.

Caractéristiques principales de Groq

| Fonctionnalité | Description |

|---|---|

| LPU Inference Engine | Inférence IA jusqu’à 10x plus rapide que les GPU. |

| API Llama | Supporte des modèles open-source comme Llama à faible coût. |

| OpenAI Compatibility | Migration fluide avec trois lignes de code. |

| Compound AI System | Combine plusieurs modèles pour des réponses précises. |

| Energy Efficiency | Réduit l’empreinte énergétique pour une IA durable. |

Fonctionnalités détaillées de Groq

LPU Inference Engine : une vitesse révolutionnaire

Le LPU™ Inference Engine est le joyau de Groq, conçu pour exécuter des modèles IA à une vitesse exceptionnelle. Par rapport aux GPU, il offre jusqu’à 10 fois plus de rapidité, atteignant 263 tokens/seconde pour Llama 3 70B. Par exemple, une application de service client peut répondre en temps réel, améliorant l’engagement utilisateur. Cette performance, couplée à une fabrication nord-américaine de haute qualité, garantit une fiabilité optimale pour les déploiements à grande échelle.

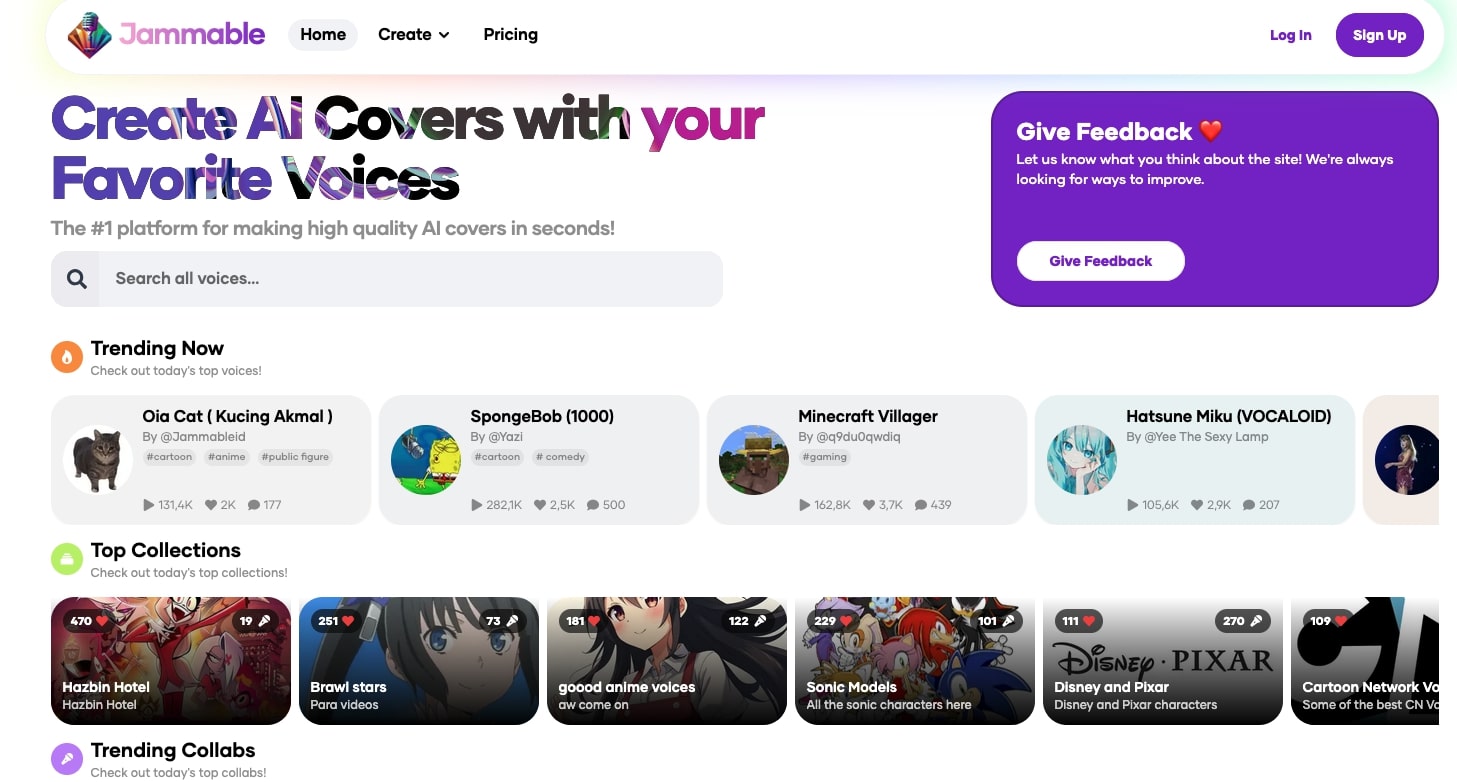

API Llama : modèles open-source accessibles

L’API Llama de Groq permet d’exécuter des modèles open-source comme Llama 3 avec une efficacité remarquable. Les développeurs peuvent intégrer ces modèles dans des applications comme des assistants vocaux ou des outils d’analyse de données, à un coût bien inférieur à celui des solutions propriétaires. Une PME peut, par exemple, créer un système de recommandation client en quelques heures.

OpenAI Compatibility : transition sans effort

Groq simplifie la migration depuis OpenAI en nécessitant seulement trois lignes de code pour adapter les applications existantes. Cette compatibilité permet aux entreprises de bénéficier de la vitesse du LPU sans réécrire leurs systèmes, tout en réduisant les coûts d’inférence. Un développeur peut ainsi passer de ChatGPT à Groq pour une application de traduction en temps réel.

Compound AI System : précision optimisée

En préversion en 2025, le Compound AI System combine plusieurs modèles pour des résultats plus précis. Par exemple, une requête sur l’analyse financière peut tirer parti de Llama pour le texte et de Gemma pour les calculs, produisant une réponse détaillée en moins d’une seconde. Cette approche est idéale pour les applications complexes comme la planification stratégique.

Energy Efficiency : une IA écoresponsable

Le LPU consomme significativement moins d’énergie que les GPU, offrant une solution durable pour l’inférence IA. Une entreprise exécutant des milliers de requêtes par jour peut réduire son empreinte carbone tout en économisant sur les coûts énergétiques. Cette efficacité énergétique, soutenue par une conception nord-américaine, positionne Groq comme un choix éthique pour les projets IA.

Avis des utilisateurs sur Groq

Groq est plébiscité pour sa rapidité et sa qualité. Les développeurs vantent ses performances, un utilisateur partageant sur un forum : « L’inférence de Llama 3 à 263 tokens/seconde a transformé mon application de génération de code. » Les benchmarks confirment une latence moyenne de 0,8 seconde pour des tâches complexes, surpassant les solutions GPU. Les entreprises apprécient la facilité de migration depuis OpenAI et l’efficacité énergétique, particulièrement pour les déploiements cloud et sur site.

Cependant, certains utilisateurs notent des limites. Groq se concentre sur l’inférence, pas l’entraînement, ce qui peut décevoir les chercheurs souhaitant personnaliser des modèles. L’interface GroqCloud est parfois jugée moins intuitive, et la compatibilité avec certains modèles moins populaires reste limitée. Malgré cela, les mises à jour fréquentes et le support communautaire renforcent son attractivité.

Tarifs de Groq

Groq propose une tarification adaptée à différents besoins :

- Gratuit : Accès limité à GroqCloud pour tester des modèles comme Llama, avec des quotas de requêtes mensuels.

- Pay-as-you-go : Facturation à l’usage, environ 0,0005 $ par million de tokens pour Llama 3, compétitif pour les applications à forte demande.

- Enterprise : Plans personnalisés pour les grandes entreprises, incluant support dédié et options sur site. Tarifs sur devis.

Les nouveaux utilisateurs peuvent obtenir des crédits gratuits pour explorer GroqCloud. Les coûts varient selon les modèles et le volume d’inférence, mais restent parmi les plus compétitifs du marché.

Alternatives à Groq

Voici trois alternatives pour l’inférence IA :

- Nvidia Triton Inference Server : Plateforme polyvalente pour l’inférence sur GPU, adaptée aux infrastructures existantes. Plus lente mais plus flexible.

- Hugging Face Inference API : Interface conviviale pour exécuter des modèles open-source. Idéale pour les débutants, mais moins optimisée pour la vitesse.

- DeepSpeed (Microsoft) : Solution open-source pour inférence et entraînement, parfaite pour la recherche. Nécessite plus de configuration.

Nvidia convient aux grandes entreprises, Hugging Face aux novices, et DeepSpeed aux chercheurs. Groq se démarque par sa vitesse et son efficacité énergétique.

Conclusion : pourquoi choisir Groq ?

Groq redéfinit l’inférence IA avec son LPU™ Inference Engine, offrant une vitesse fulgurante, une qualité irréprochable et une efficacité énergétique remarquable. Conçus et fabriqués en Amérique du Nord, ses systèmes garantissent une fiabilité industrielle pour les applications cloud et sur site. Que vous développiez des chatbots, des outils d’analyse ou des systèmes embarqués, Groq accélère vos projets tout en réduisant votre empreinte carbone. Malgré une focalisation sur l’inférence, ses performances et sa tarification compétitive en font un leader en 2025.

Envie d’une IA plus rapide et durable ? Testez Groq gratuitement et découvrez la puissance de l’inférence nouvelle génération !